昨天,各路自媒体竞相解读Sam Altman的年终长文《反思》(Reflection),热衷于炒作"OpenAI已知如何构建AGI"的话题。标题党充斥,观点纷杂,却鲜有人能触及核心要义。

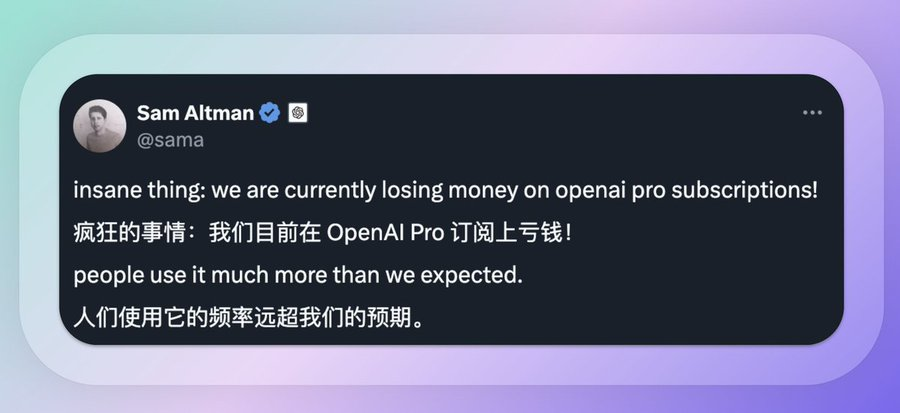

就在整个科技圈仍沉浸在长文讨论的热潮中时,Altman又在社交媒体平台发布了一条简短却耐人寻味的推文。

"insane thing: we are currently losing money on openai pro subscriptions!"(疯狂的事情:我们目前在OpenAI Pro订阅上亏钱!) "people use it much more than we expected."(人们使用它的频率远超我们的预期。)

这条推文乍看平常,却与他那篇引发广泛讨论的长文《反思》形成了微妙的呼应。当大多数人还在津津乐道于OpenAI"已知如何构建AGI"的宏大叙事时,这条关于当下AI公司经营状况的推文,反而可能蕴含着更值得关注的信息。因为Altman曾说,"我原以为我们能赚到一些钱。"这句话承认了一个出人意料的事实:即便每月收取200美元的订阅费,ChatGPT Pro的服务依然在亏损,这不是简单的表态。

如果我们将这两份看似风马牛不相及的内容结合起来,一个更深层的产业图景开始显现。在狂热的AGI憧憬之下,是AI产业发展面临的巨大现实挑战。正是这个被多数分析忽视的维度,或许才是理解OpenAI,乃至整个AI产业发展的关键。

让我们剖析推文背后的经济逻辑。数据显示,尽管OpenAI已获得约200亿美元的融资,2023年实现了37亿美元的收入,但预计亏损高达50亿美元。仅ChatGPT的运营就让公司每天花费约70万美元。这种巨额亏损,与Altman在长文中的豪迈论断形成鲜明对比。

"将近九年前,我们创建了OpenAI,因为我们坚信AGI不仅可能实现,还能成为人类历史上最具革命性的技术之一。"Altman在长文开篇这样写道。

而现在,他更是明确宣告:"如今,我们对如何实现AGI已经胸有成竹。我们相信,到2025年,第一批AI代理将正式成为'劳动力'中的一员。"这种看似矛盾的状况,其实反映了AI产业发展的深层逻辑。

正如Altman在长文中坦言:"过去的两年里,我们几乎从零开始,围绕这项全新的技术构建了一整家公司。没有任何人能告诉你如何做,因为除了亲身实践外,别无他法。而当一个技术领域完全新生时,更无人能够为你指引明确的道路。"

巨额亏损的主要来源包括员工薪资、办公场所租金,但最关键的是AI训练所需的基础设施投入。

这印证了Altman在长文中的一个重要观点:"我们的愿景始终坚定不移,但策略需要随着环境不断调整。例如,最初我们完全没想到需要建立一家产品公司;我们曾以为做好研究就是全部。我们也没预料到资金需求会如此巨大。"

这种高成本主要源于两个方面。

首先是算力需求呈指数级增长。要实现AGI,需要更大的参数量和更长的推理时间,这直接推动了对高性能计算硬件的巨大需求。事实上,OpenAI正在为新一轮融资进行重组,但发现所需资金"远超预期"。这再次印证了AI发展对算力的巨大胃口。

其次是能源消耗问题。当模型规模不断扩大,能源效率成为制约发展的另一个瓶颈。这也解释了为什么在展望超智能未来时。

Altman强调:"有了超智能,科学发现和创新的速度将大幅加快。"要突破效率瓶颈,需要新一代芯片架构的支持。

从产业链角度看,这种高成本结构塑造了明确的投资机会:

上游芯片制造商:英伟达的龙头地位将更加稳固,其股价有望继续创新高

数据中心建设:云计算巨头们的基建支出将维持高位

还没有评论,来说两句吧...