“过去一年中,对我们来说,领域内最重要的突破是这些能够进行推理的新模型,”Altman 在访谈中解释道。这标志着 AI 发展范式的一种转变:从简单依靠扩大模型规模和增加预训练数据,转向了一种更精细、更有针对性的方法。在这种新方法中,强化学习发挥着核心作用。

传统的大语言模型遵循一个相对简单的扩展逻辑:每一代模型的计算能力大约是前一代的 100 倍。正如 Altman 所说:“在过去的范式中,我们只做预训练,从 GPT-1 到 GPT-4,每个版本都大约是前一个版本的 100 倍计算能力,每次都会出现重大的新特性。”然而,这种简单的扩展策略似乎已经遇到了瓶颈。

为此,OpenAI 开始探索一种全新的方向:专注于开发通过强化学习优化的专业化模型。

这些模型通过强化学习进行优化,特别擅长处理具有明确答案的任务,如编程和数学问题。这种方法带来了惊人的计算效率提升,使得他们能够用更小的模型达到此前需要等到 GPT-6 才可能实现的性能水平。

比如,在编程领域,这种新方法的效果格外明显。他们的第一个推理模型 o1 在全球竞争性程序员中排名为前一百万位,这在当时就已经被认为是个重要突破。随后,模型的能力快速提升,很快进入了前一万名。到 2024 年 12 月,他们公开发布的 o3 模型已经达到了第 175 位。而目前,他们内部的最新模型已经达到约第 50 位的水平。Altman 甚至预计,在今年年底有望排名第一。

不过,这种新方法也存在其局限性。“当我们采用这种新方式时,模型并不是在所有方面都会变得更好,而是在特定维度上取得突破,”他解释道。这种专门化的特点使得新一代模型在编程领域表现出色,但在创造性任务,如发明全新算法或发现新的科学知识方面,仍有提升空间。

为了突破这些限制,OpenAI 正在尝试一个新的方向:把大规模预训练模型与专业化的推理能力结合起来。Altman 认为,这种结合可能带来重要突破,带来“在真正新的科学知识上的第一个迹象或某种生命迹象。”

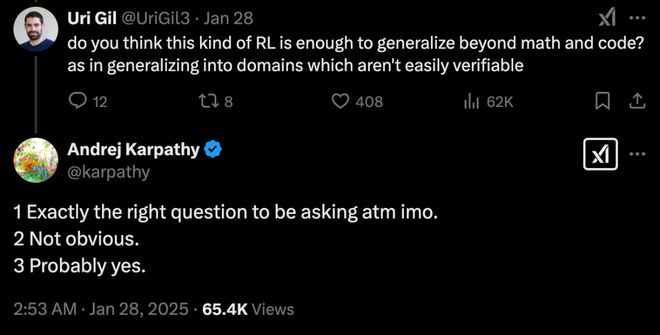

实际上,DeepSeek-R1 这款推理模型已将强化学习带来的推理能力泛化到了其他领域,给写作等通用场带来的能力提升,已经让我们看到这种可能。

图丨 Andrej Karpathy 关于强化学习能否泛化的看法(来源:X)

在访谈中,Altman 还透露了 OpenAI 在未来的规划。他表示,在未来 6 到 12 个月内,他们将专注于开发小型但高效的推理模型。这些模型不仅要在科学和技术领域保持优势,还将逐步扩展到其他领域。同时,他们也在努力实现多模态集成,让用户能够同时使用语音、代码编写、画布创作等多种功能。

“到今年年底,我们希望能够推出一个新的模型,“Altman 说,“如果用户使用 Pro 版本,将计算能力调到最大,就能向它提出非常困难的问题。虽然这个模型可能需要几个小时的思考时间,可能需要使用多种工具,但最终能够独立完成任务。不过现在还不能期待它发现全新的科学原理。”

另外,在开源问题上,OpenAI 的立场正在发生微妙的变化。这一变化部分正是对 Deepseek 发布开源推理模型 R1 的回应。“我们会走向开源,”Altman 说,“虽然我现在还不能确切说明会开源什么或什么时候开源,但社会似乎已经准备好接受开源模型带来的各种影响。”

Altman 表示,OpenAI 在确保模型安全性和稳健性方面已经取得了进展。虽然开源模型的使用方式可能不会完全符合预期,但他们相信在大多数情况下,这些模型会发挥应有的作用。

2025 年,OpenAI 会如 Altman 所宣称的那样更开放、更领先吗?让我们拭目以待。

参考资料:

1.

排版:初嘉实

还没有评论,来说两句吧...